「どの翻訳エンジンが良いのかわからない。」

機械翻訳の導入を検討されているお客様からよく聞く声です。

機械翻訳の品質評価の方法としては、BLEUスコアやTERスコアといった自動評価がよく知られていますが、あくまでも機械的に行う評価のため、BLEUスコアやTERスコアの評価が実際の品質と一致しない場合も多くあります。

そのため、ヒューマンサイエンスでは、機械による自動評価だけでなく、ネイティブ翻訳者による評価もあわせて行い、機械翻訳エンジンの品質を確実に見極めます。

評価方法

3〜5つのエンジンのアウトプットを人による評価(ネイティブ翻訳者による評価)と自動評価(BLEUスコア、TERスコア)の二つの方法で評価します。

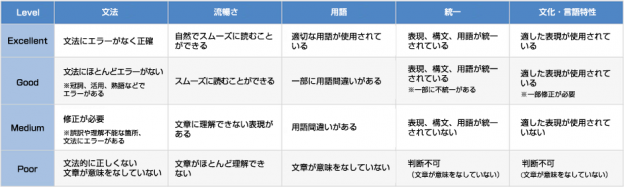

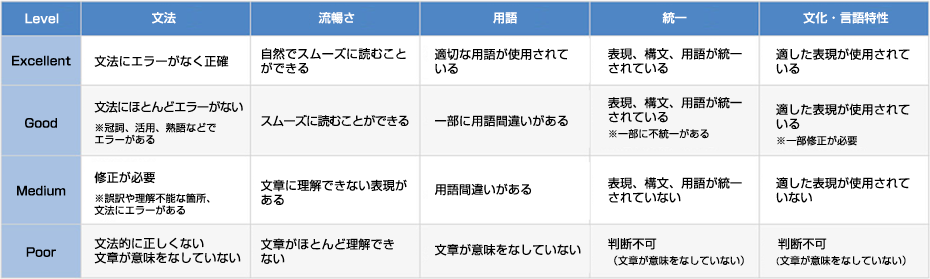

複数のネイティブ翻訳者による品質評価

MTエンジンのアウトプットを「文法」「流暢さ」「用語」「統一」「文化・言語特性」という5つの観点で「Excellent」「Good」「Medium」「Poor」の4つの基準で評価します。

- Excellent…とても良い品質。人の翻訳と比べても遜色なく、ほとんど修正不要。

- Good…良い品質。少しエラーはあるが、原文の意味を理解できる。

- Medium…まあまあの品質。修正が必要。

- Poor…悪い品質。一から翻訳し直す必要がある。

機械翻訳の後には、訳文をよりよくするポストエディットという作業が必要になります。アウトプットの品質を、以下の2つの基準で評価します。

- ポストエディットによって改善できる品質か

- ポストエディットするよりも、一から翻訳し直した方が良い品質か

ポストエディットで目標とする品質によっても、ポストエディットできる品質か、一から翻訳し直した方が良い品質かは異なりますので、目標品質をヒアリングさせていただいた上で、評価を実施します。

スコアによる自動評価

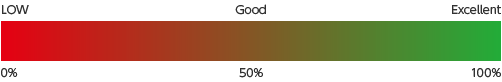

- BLEUスコア

- TERスコア

MTシステムの評価において、最も広く用いられている自動評価尺度です。

参照訳(正解)と翻訳結果を比較して、類似度に基づいて翻訳の精度を評価します。0%から100%の間でスコアを算出し、スコアが高くなるほど、品質が向上します。50%以上のスコアになると、品質が良いと言えます。

翻訳のエラー率を算出するための自動評価尺度です。

参照訳(正解)を得るために、翻訳結果に対して行う修正(置換・挿入・削除・シフト)の割合を算出します。

0%から100%の間でエラー率を算出し、スコアが低くなるほど、エラーが少なく、ポストエディットの負荷が減るということになります。

30%以下の数値になると、品質が良いと言えます。

品質評価分析レポート

関連サービス

機械翻訳セミナー開催予定

機械翻訳セミナーは毎月開催しております。

セミナー案内メールご希望の方は下記ボタンから登録ください。